如果您无法下载资料,请参考说明:

1、部分资料下载需要金币,请确保您的账户上有足够的金币

2、已购买过的文档,再次下载不重复扣费

3、资料包下载后请先用软件解压,在使用对应软件打开

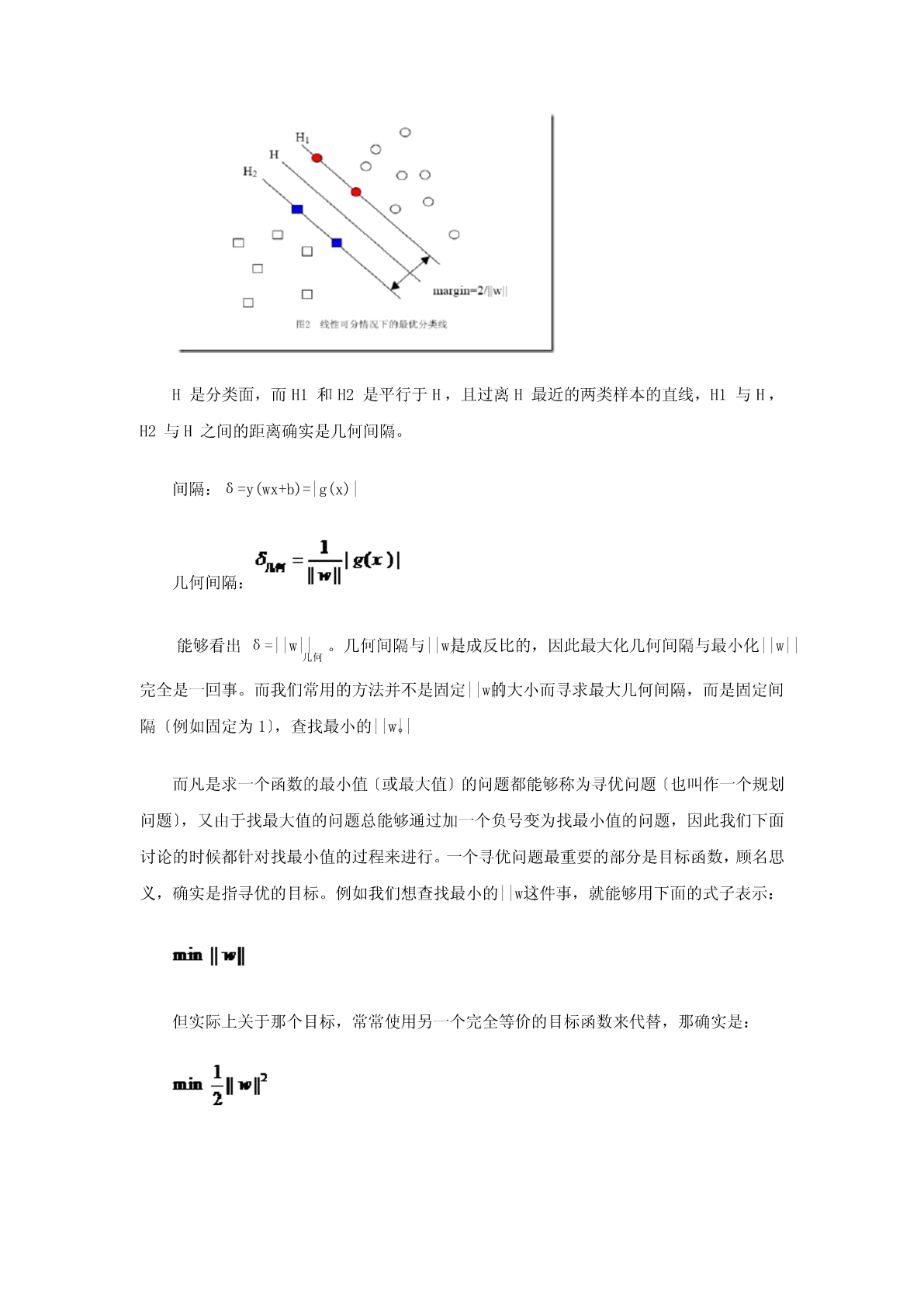

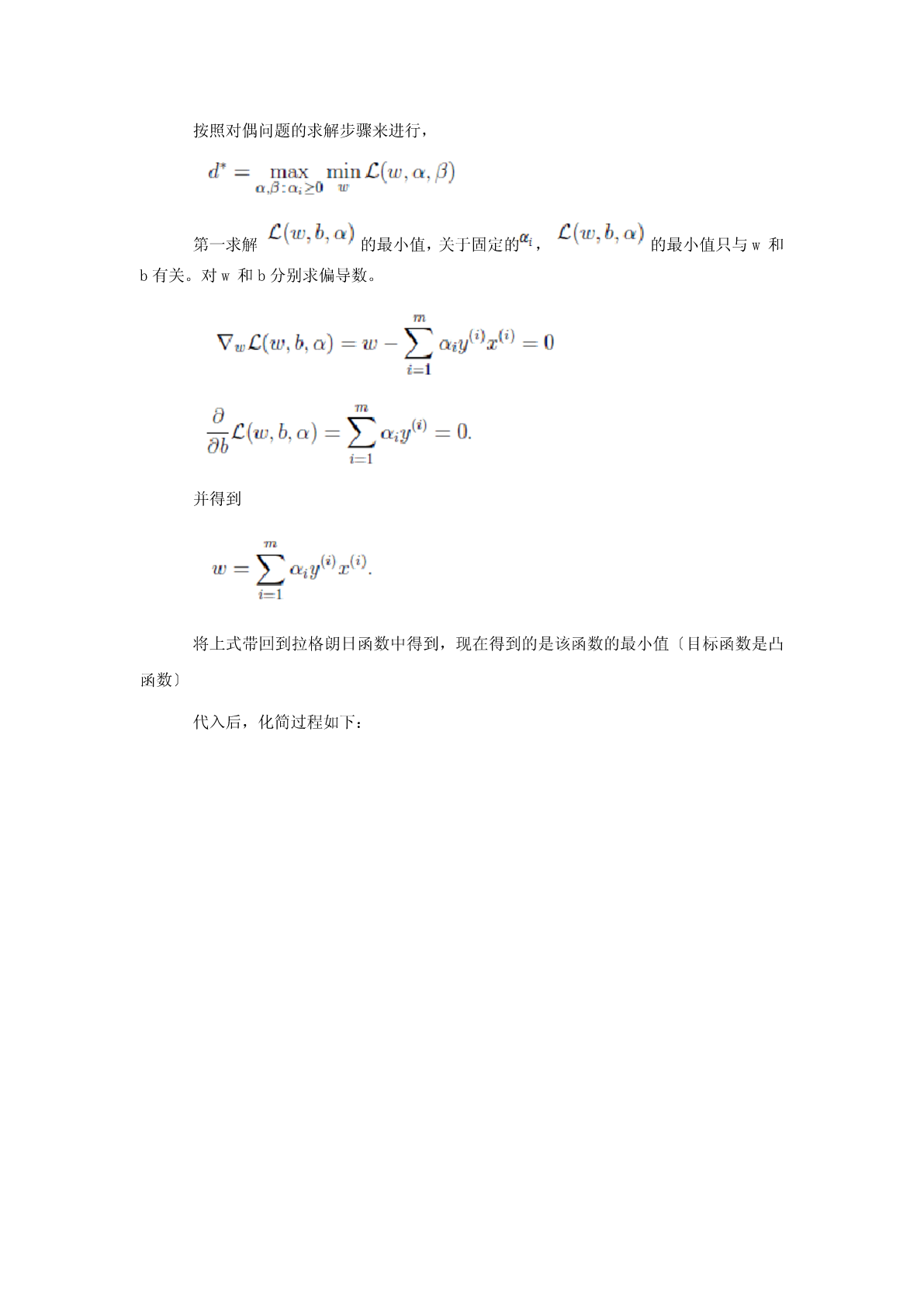

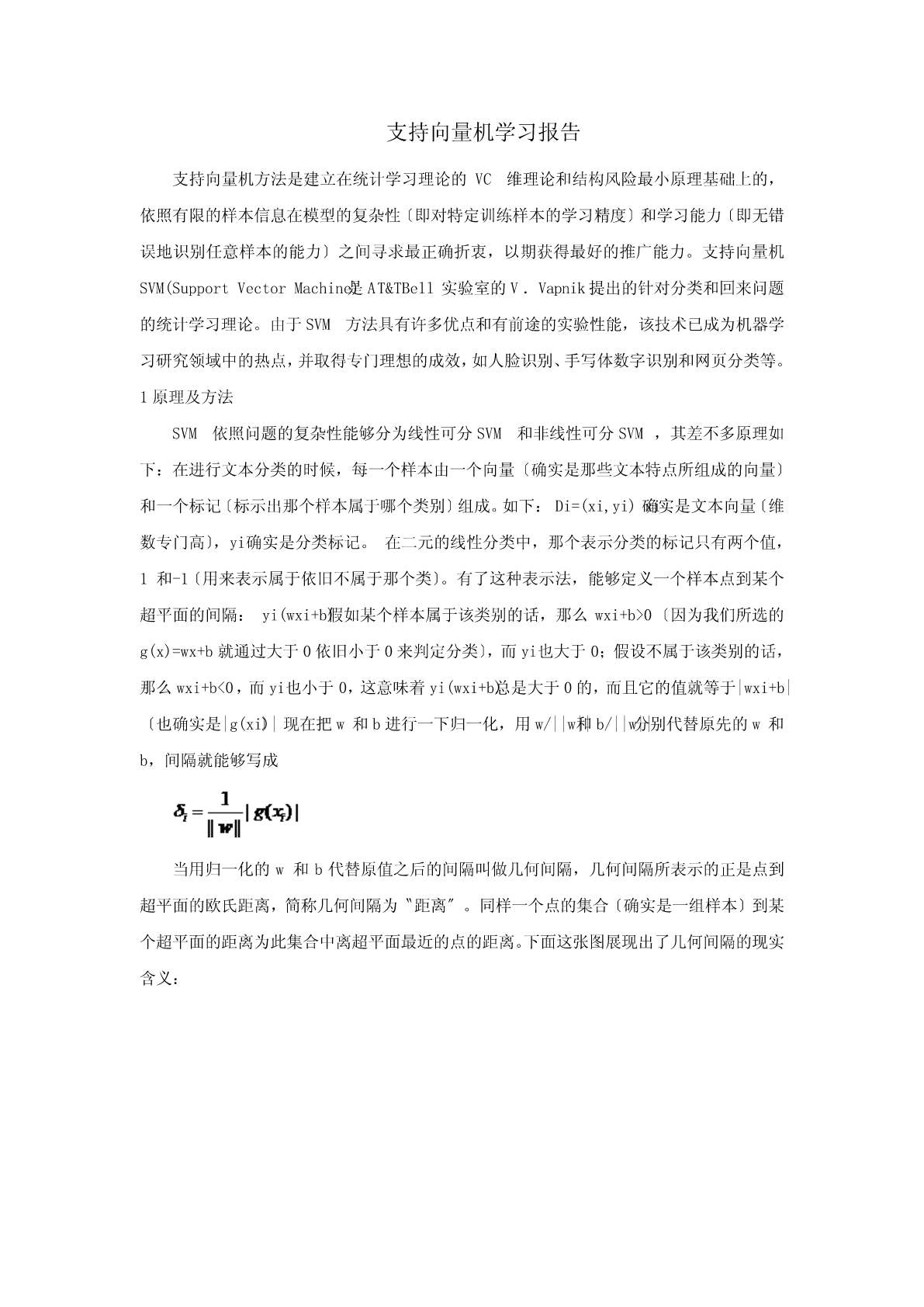

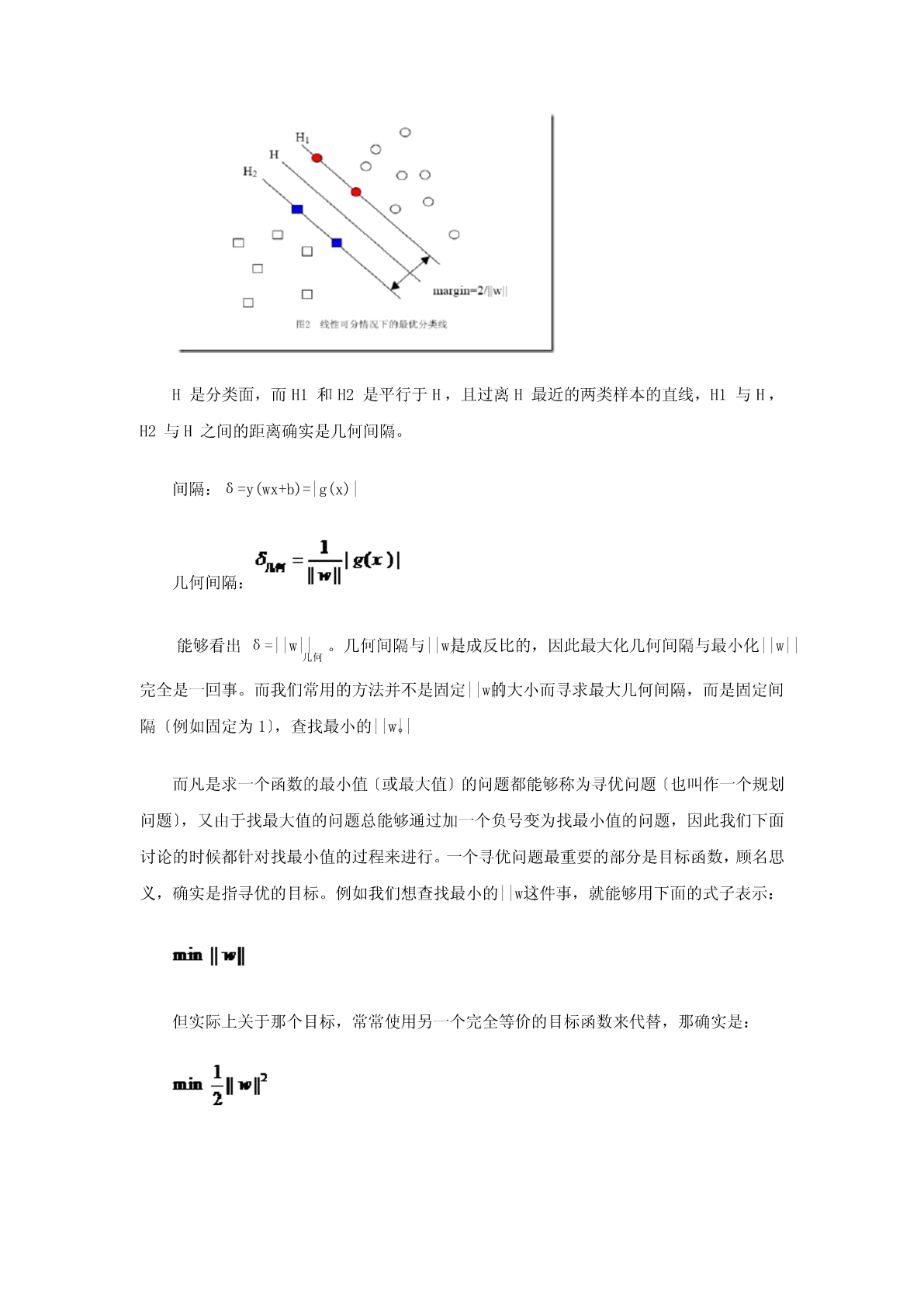

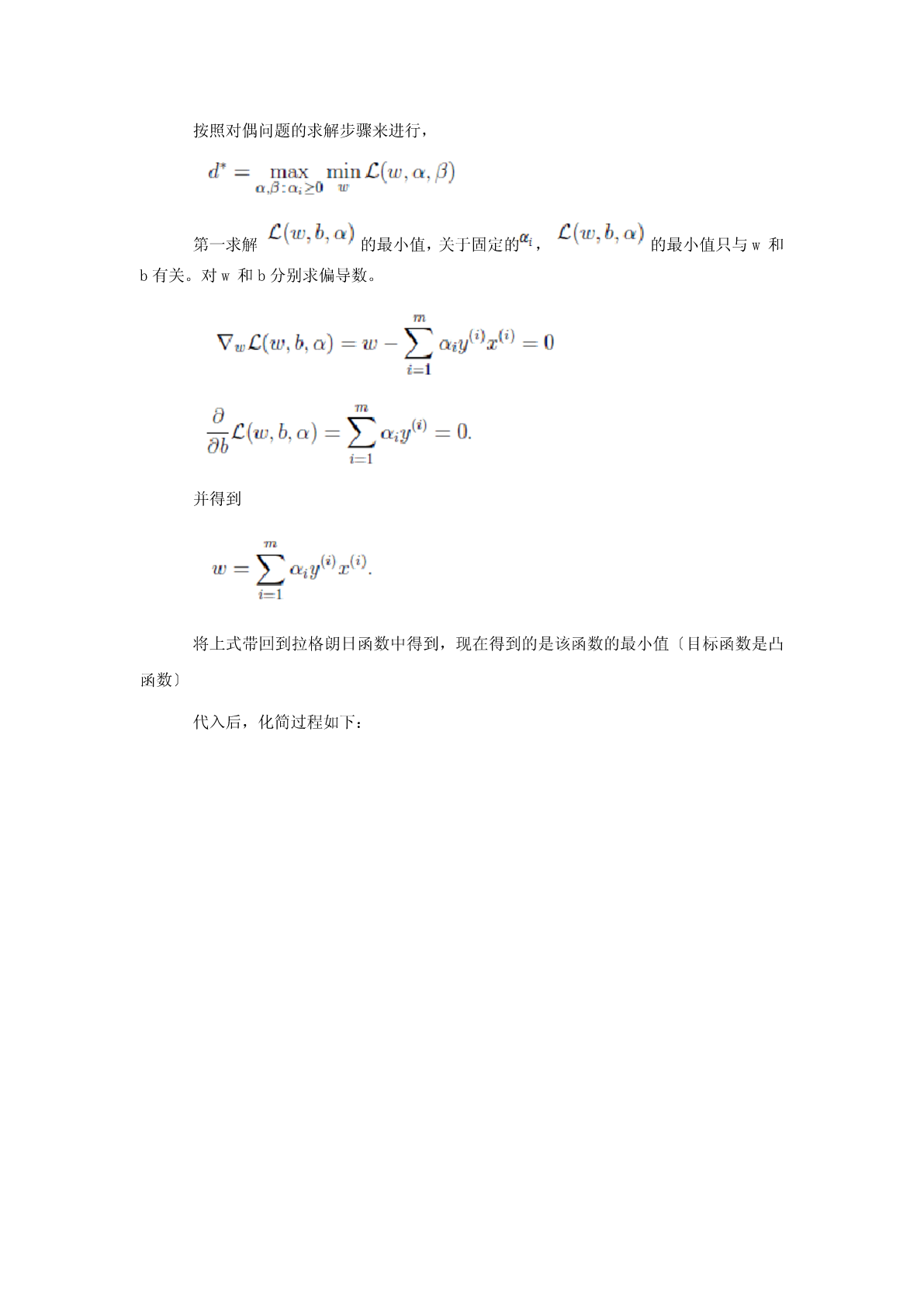

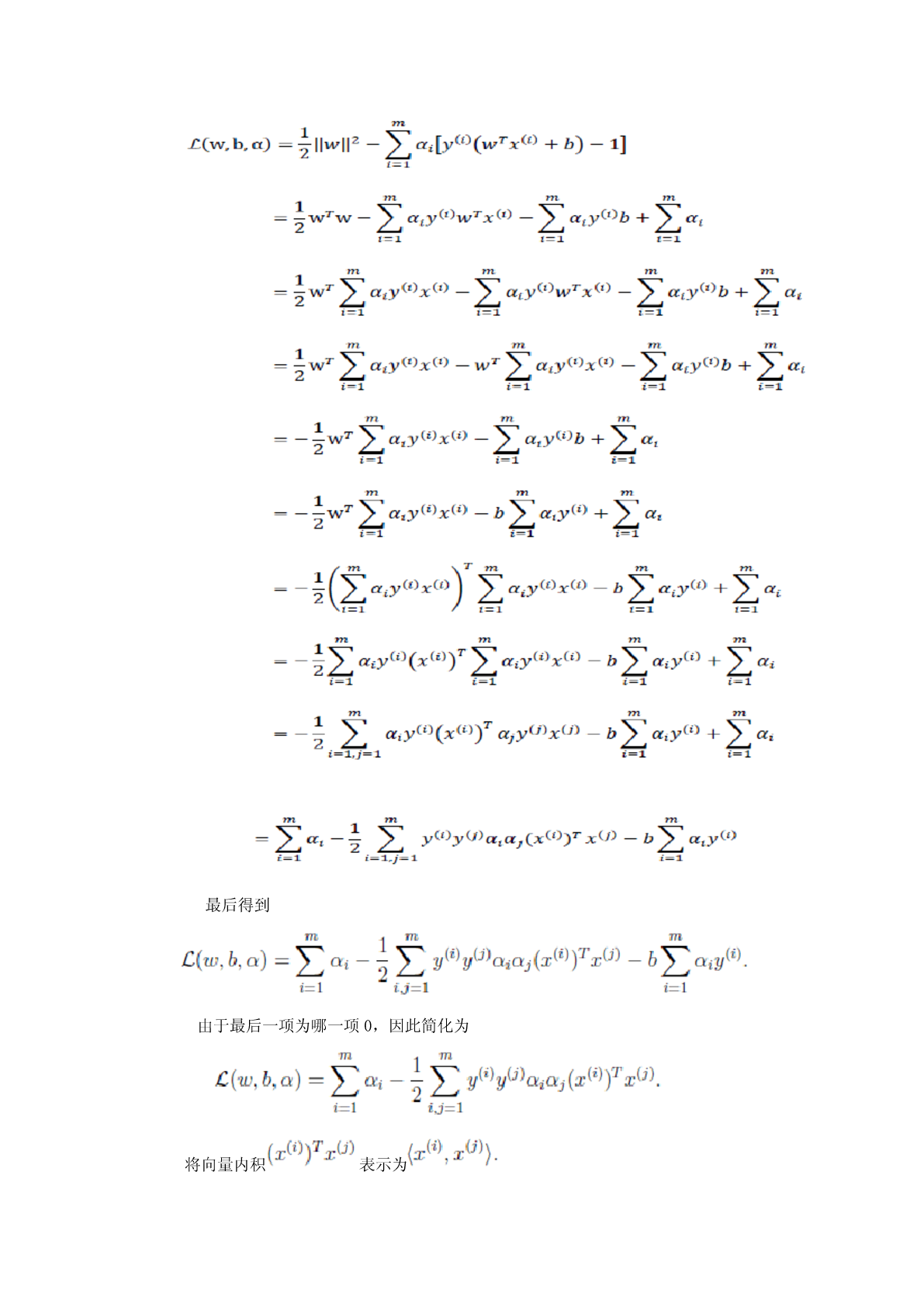

人工智能大作业21研究报告题目支持向量机学习报告学号学生支持向量机学习报告支持向量机方法是建立在统计学习理论的VC维理论和结构风险最小原理基础上的,依照有限的样本信息在模型的复杂性〔即对特定训练样本的学习精度〕和学习能力〔即无错误地识别任意样本的能力〕之间寻求最正确折衷,以期获得最好的推广能力。支持向量机SVM(SupportVectorMachine)是AT&TBell实验室的V.Vapnik提出的针对分类和回来问题的统计学习理论。由于SVM方法具有许多优点和有前途的实验性能,该技术已成为机器学习研究领域中的热点,并取得专门理想的成效,如人脸识别、手写体数字识别和网页分类等。1原理及方法SVM依照问题的复杂性能够分为线性可分SVM和非线性可分SVM,其差不多原理如下:在进行文本分类的时候,每一个样本由一个向量〔确实是那些文本特点所组成的向量〕和一个标记〔标示出那个样本属于哪个类别〕组成。如下:Di=(xi,yi)确实是xi文本向量〔维数专门高〕,yi确实是分类标记。在二元的线性分类中,那个表示分类的标记只有两个值,1和-1〔用来表示属于依旧不属于那个类〕。有了这种表示法,能够定义一个样本点到某个超平面的间隔:yi(wxi+b)假如某个样本属于该类别的话,那么wxi+b>0〔因为我们所选的g(x)=wx+b就通过大于0依旧小于0来判定分类〕,而yi也大于0;假设不属于该类别的话,那么wxi+b<0,而yi也小于0,这意味着yi(wxi+b)总是大于0的,而且它的值就等于|wxi+b|〔也确实是|g(xi)|〕现在把w和b进行一下归一化,用w/||w||和b/||w||分别代替原先的w和b,间隔就能够写成当用归一化的w和b代替原值之后的间隔叫做几何间隔,几何间隔所表示的正是点到超平面的欧氏距离,简称几何间隔为〝距离〞。同样一个点的集合〔确实是一组样本〕到某个超平面的距离为此集合中离超平面最近的点的距离。下面这张图展现出了几何间隔的现实含义:H是分类面,而H1和H2是平行于H,且过离H最近的两类样本的直线,H1与H,H2与H之间的距离确实是几何间隔。间隔:δ=y(wx+b)=|g(x)|几何间隔:能够看出δ=||w||。几何间隔与||w||是成反比的,因此最大化几何间隔与最小化||w||几何完全是一回事。而我们常用的方法并不是固定||w||的大小而寻求最大几何间隔,而是固定间隔〔例如固定为1〕,查找最小的||w||。而凡是求一个函数的最小值〔或最大值〕的问题都能够称为寻优问题〔也叫作一个规划问题〕,又由于找最大值的问题总能够通过加一个负号变为找最小值的问题,因此我们下面讨论的时候都针对找最小值的过程来进行。一个寻优问题最重要的部分是目标函数,顾名思义,确实是指寻优的目标。例如我们想查找最小的||w||这件事,就能够用下面的式子表示:但实际上关于那个目标,常常使用另一个完全等价的目标函数来代替,那确实是:当w2到最小时,||w||也达到最小,反之亦然〔前提因此是||w||描述的是向量的长度,因而是非负的〕。将约束条件改写为:从KKT条件得知只有函数间隔是1〔离超平面最近的点〕的线性约束式前面的系数,也确实是说这些约束式,关于其他的不在线上的点(),极值可不能在他们所在的范畴内取得,因此前面的系数.实线是最大间隔超平面,假设×号的是正例,圆圈的是负例。在虚线上的点确实是函数间隔是1的点,那么他们前面的系数,其他点差不多上。这三个点称作支持向量。构造拉格朗日函数如下:按照对偶问题的求解步骤来进行,第一求解的最小值,关于固定的,的最小值只与w和b有关。对w和b分别求偏导数。并得到将上式带回到拉格朗日函数中得到,现在得到的是该函数的最小值〔目标函数是凸函数〕代入后,化简过程如下:最后得到由于最后一项为哪一项0,因此简化为将向量内积表示为现在的拉格朗日函数只包含了变量。然而我们求出了才能得到w和b。接着是极大化,第一由于目标函数和线性约束差不多上凸函数,而且那个地点不存在等式约束h。存在w使得关于所有的i,。因此,一定存在使得是原问题的解,是对偶问题的解。假如求出了,依照即可求出w〔也是,原问题的解〕。然后即可求出b。即离超平面最近的正的函数间隔要等于离超平面最近的负的函数间隔。由于前面求解中得到考虑,依照求解得到的,